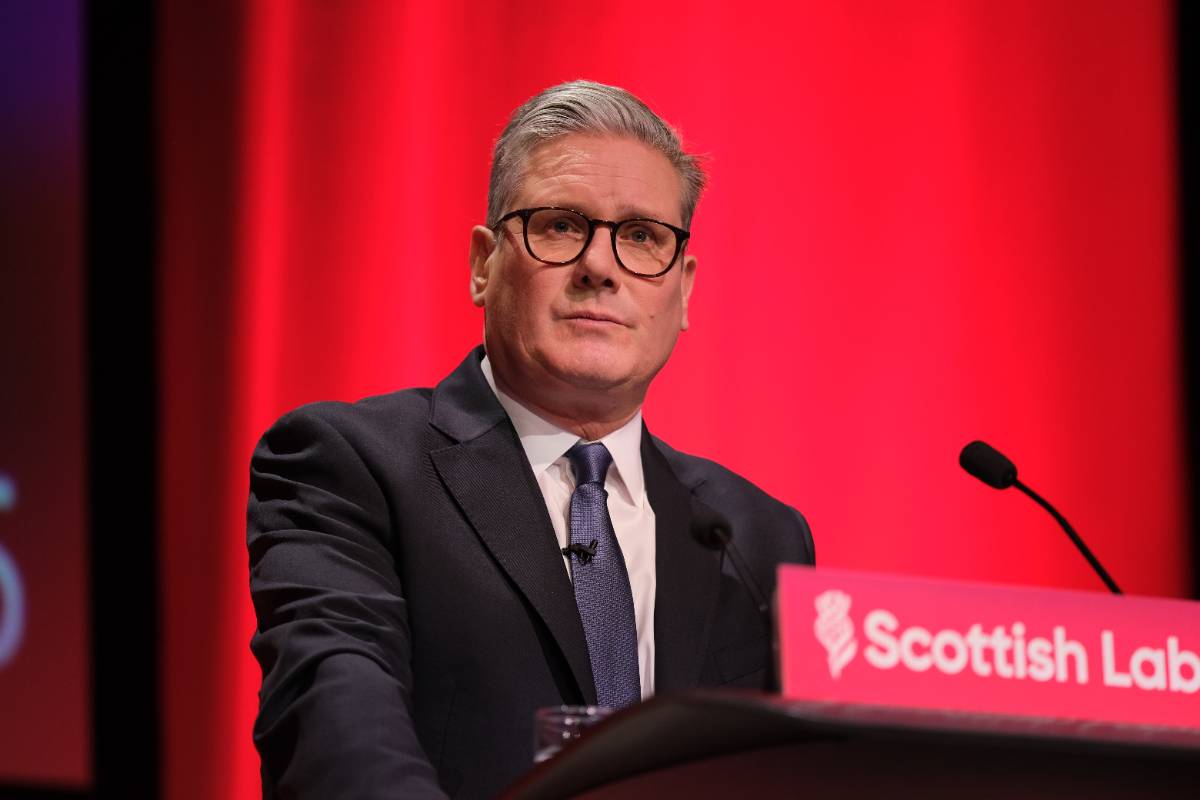

Nieuwe techniek roept vragen op: wat moeten christenen met ChatGPT?

De laatste tijd verschijnen veel artikelen in kranten en nieuwsitems op televisie over ChatGPT. Omdat ChatGPT schijnbaar een antwoord op alle vragen weet, rijst de vraag of we dit soort technologie wel willen gebruiken. Of dat het onontkoombaar is. Ik probeer na te gaan wat de ethische implicaties van ChatGPT zijn. En vooral wat het betekent voor ons begrip van feit, fictie en waarheid.

ChatGPT is gebaseerd op GTP-3, een zogenaamd Large Language Model. Deze modellen zijn in staat om op basis van natuurlijke taal, spreek- of schrijftaal, een antwoord te geven in dezelfde natuurlijke taal. Er zijn ook Large Langauge Models die op basis van een vraag of opdracht, geformuleerd in natuurlijke taal, een afbeelding kunnen genereren. Dit wordt Generatieve AI genoemd: AI die tekst, afbeeldingen of video’s genereert. Maar voor deze discussie gaan we uit van ChatGPT van OpenAI, Microsoft Bing, Replika, Google Bard en vele anderen. Met deze machines kan je een dialoog voeren en de kunstmatige intelligentie, door middel van vragen en antwoorden, tekstuele opdrachten laten uitvoeren. Je kunt de software vragen een tekst te generen over het onderwerp dat jezelf kiest.

Hoe werkt het dan? Op basis van gigantische hoeveelheden voor beeldteksten, gehaald van het internet, heeft de kunstmatige intelligentie geleerd hoe een taal in elkaar steekt. Welke woorden volgen op welke woorden. En dat lukt de machine nu heel goed. De zinnen die de software produceert zijn grammaticaal en syntactisch correct. Goed genoeg om als menselijke tekst door te gaan.

Waar is ChatGPT goed in?

Waar ChatGPT redelijk goed in is, is het maken van fictie. Verhaaltjes maken gaat het algoritme redelijk af, al is de verhaallijn soms brokkelig, zijn de karakters vlak en is de diepgang matig. Er worden nu zoveel fictie geschreven door ChatGPT dat een Amerikaans fantasytijdschrift wordt overspoeld met verhalen geschreven door de computer. ‘Het is een enorme hype. Niet-schrijvers zien het als een makkelijke manier om geld te verdienen, maar gaan wat anders doen wanneer ze bot vangen.’ zegt Martijn Lindeboom in een artikel in de Volkskrant.

Waar is ChatGPT slecht in?

Maar wat is dan het grote probleem rondom deze taalsoftware? Ten eerste presenteert ChatGPT alle antwoorden met zekerheid. Goede en foute antwoorden. De software twijfelt niet en kan de grootste onzin met grote zekerheid presenteren. ChatGPT kan zelf antwoorden verzinnen, hallucineren. De lezer van de antwoorden kan niet bepalen of ChatGPT de waarheid schrijft. Daarvoor moet de lezer het onderwerp waarover geschreven wordt kennen. Maar wat als de lezer die kennis niet heeft? Mensen hebben snel de neiging uitspraken van computers als waar te bestempelen. ‘Mensen hebben de neiging alles wat de bot zegt klakkeloos over te nemen.’ schrijft het vakblad AG Connect.

Allerlei ethische bezwaren

Snel kwamen er allerlei ethische bezwaren op tegen ChatGPT en andere, soortgelijke algoritmen. Laat ik een korte opsomming geven van enkele van de problemen die experts op het gebeid van AI en ethiek zien:

1. Scholieren en studenten hebben ChatGPT allang ontdekt als een gemakkelijke methode om een scriptie of verslag te schrijven. Leraren waren daar niet op voorbereid en proberen nu methoden te verzinnen om te bepalen wie of wat een tekst heeft geschreven. Daar worden nu tools voor gemaakt, maar misschien moeten we schrijfopdrachten anders gaan uitvoeren. Terug naar pen en papier of toch iets anders? Bij de opkomst van zoekmachines speelde dezelfde discussie, maar daar zijn we nu ook aan gewend geraakt.

2. ChatGPT verbruikt veel elektriciteit en stoot daarmee indirect ook veel COâ‚‚ uit. Dit is een algemeen probleem in de ICT en wordt met de verdere digitalisering steeds erger. Zoals een collega zie: ‘Als je energie wilt besparen, schrijf je eigen e-mails en laat het niet door een AI doen.’ Luiheid leidt draagt bij aan de klimaatcrisis.

3. Voor het voorkomen van ongewenste antwoorden worden aan ChatGPT filters toegevoegd. Bepaalde vragen die politiek gevoelig, discriminerend of pornografisch zijn, worden eruit gefilterd. Hiervoor worden in Kenia mensen ingehuurd voor $2 per uur. De ontwikkeling van sociale media en kunstmatige intelligentie gaat gepaard met uitbuiting. Het verwijderen van toxische content is en blijft (onderbetaald) mensenwerk.

4. Large Language Models, waar ChatGPT er een van is, maken gebruik van enorme verzamelingen data. Deze data kunnen auteursrechtelijk zijn beschermd. Maar de tools hergebruiken deze data zonder daarvoor toestemming te hebben gevraagd. Vooral bij zogenaamde kunstwerken gemaakt door AI zijn kunstenaars oprecht bezorgd dat hun werk wordt geplagieerd.

Maar ik heb een groter bezwaar tegen het gebruik van ChatGPT: dat het de waarheid geweld aandoet. Wanneer je ChatGPT gebruikt om fictie te schrijven, een spookje of een gedicht, is er weinig aan de hand. De verhalen zijn dan wel middelmatig, maar dat kan onder omstandigheden voldoende zijn. Niet al het proza hoeft uitstekend te zijn.

Maar als het gaat om het beschrijven van feiten, is er wel een ethisch probleem. OpenAI, de bouwer van ChatGPT, waarschuwt al op hun website dat de antwoorden die de AI geeft wel eens foutief kunnen zijn. OpenAI geeft zelf de volgende waarschuwingen. ChatGPT…

· kan af en toe onjuiste informatie genereren;

· kan af en toe schadelijke instructies of bevooroordeelde inhoud produceren;

· beperkte kennis van wereld en gebeurtenissen na 2021.

Maar ChatGPT geeft niet aan wanneer dit het geval is. Of wanneer er een kans is dat dit het geval is. Ook foute of slechte antwoorden worden gepresenteerd alsof er geen twijfel is. ChatGPT twijfelt nooit, en bluft door onwaarheden als waar te presenteren. En dat is ook niet verbazingwekkend wanneer je grote delen van het internet als informatiebron gebruikt. Vanwege de hoeveelheid desinformatie die al online is, die wordt ingevoerd in de trainingsmodellen voor grote taalmodellen, kunnen mensen die ze gebruiken ook onbedoeld onwaarheden verspreiden. Niet alles wat op het internet staat is waar, om het maar eens zachtjes uit te drukken.

Ook geeft ChatGPT geen bronvermeldingen. Klassieke zoekmachines linken naar de brondocumenten, het kennissysteem IBM Watson liet de bronnen ook zien. Maar het Deep Learning algoritme van ChatGPT kan helemaal niet de bronnen geven. Het husselt verschillende gegevens bij elkaar tot mooie volzinnen. De antwoorden zijn in zeker zin toevallig.

Daarnaast kunnen de antwoorden die ChatGPT geeft ook vooroordelen bevatten. Ze kunnen dan wel waar zijn, maar zijn dan sterk gekleurd. Waar de discussie rondom kunstmatige intelligentie de laatste jaren vooral draait op het vermijden van ‘bias’, blijkt er nu weer een AI-tool beschikbaar te zijn gekomen die weer eens vooroordelen verspreid. Dit wordt pas echt problematisch wanneer door ChatGPT gegeven teksten met vooroordelen weer op het internet worden geplaatst. En die dan weer door ChatGPT als broninformatie worden gebruikt. Kunstmatige Intelligentie kan vooroordelen versterken en ChatGPT is geen uitzondering daarop.

Nepnieuws & Co

Als sinds mensenheugenis wordt er nepnieuws, roddels, onwaarheden en misleidende informatie gemaakt en verspreid. Deze “foute” informatie wordt verspreid uit eigen belang, politiek belang, macht maar ook uit domheid en onwetendheid. Niet altijd is kwade opzet in het spel, al kunnen de gevolgen wel kwaadaardig zijn. Het verspreiden van nepnieuws is vaal wel opzettelijk. Trollen die een alternatieve waarheid, of gewoon onwaarheden, verspreiden hebben politieke doelen. Sociale media bieden deze trollen een gemakkelijke methode hun berichten te verspreiden. Met verdergaande maatschappelijke gevolgen voor democratie en cohesie. ‘Democratie is geen product, maar een gemeenschappelijk proces. En dat wankelt door AI.’ schrijft Maxim Februari in NRC.

Daarin verandert Generatieve AI weinig. De menselijke eigenschap op feiten naar zijn hand te zetten, of om fictie als feit te presenteren, faciliteert Generatieve AI alleen maar. Maar is er dan niets veranderd?

Industrialisatie van onwaarheden

Wat Generatieve AI wel kan is op grote schaal bedrog faciliteren. Nu al zijn beveiligers bang dat pishing-mails door dergelijke tools zodanig geschreven kunnen worden, dat ze amper meer van oprechte berichten onderscheiden kunnen worden. Ook wordt het gemakkelijker nepnieuws te maken. ChatGPT en anderen zijn goed in het fantaseren, dus kunnen ze ook onwaarheden schrijven. Volgens mij zijn deze algoritmen er zelfs beter in dan het beschrijven van waarheden. Ook al gaan techbedrijven abonnementsgeld vragen voor dergelijke schrijfopdrachten, het schrijven van een artikel zonder controles wordt veel sneller en goedkoper dan een waarheidsgetrouw artikel. Journalisten en onderzoekers kosten geld. Het schrijven van een doorwrochte tekst kost tijd.

We zullen daarom meer te maken krijgen met teksten die onwaarheden bevatten. Uit hebzucht, macht of onwetendheid. Als we niet meer eenvoudig waarheden van onwaarheden kunnen onderscheiden, heeft dat maatschappelijke gevolgen. Wie kan ik nog vertrouwen? Welke waarheid is waar? Is alles dan relatief en bestaat de waarheid niet meer? Het is ook belangrijk je te realiseren dat degene die geld en macht hebben de waarheid nu makkelijker naar hun hand kunnen zetten. Wie toegang heeft tot kunstmatige intelligente systemen, en daarbij ook nog controle over de distributiekanalen als sociale media, kan zijn versie van de waarheid, of zijn eigen waarheid, veel gemakkelijker verspreiden dan een ander met minder middelen. We zien dit nu al gebeuren bij Twitter. Ook dit is niet nieuw in de geschiedenis. Maar kunstmatige intelligentie maakt het wel een stuk gemakkelijker.

Wat is waarheid?

‘Wat is waarheid?’, vroeg Pontius Pilatus zich af. Ik geloof niet dat hij het filosofisch bedoelde, maar meer als een machtsvraag. Wat is waarheid wanneer ik, de machthebber over leven en dood, zelf kan bepalen wat waar is? Als Christenen zijn we op zoek naar de waarheid die Christus is als de weg, de waarheid en het leven. Maar deze waarheid is voor iedereen die het horen en zien wil. Niet alleen voor een exclusieve club uitverkorenen.

Niet lang geleden werd de cultuur gestempeld door het relativisme. Waarheid was ‘onkenbaar’. Misschien bestond het wel ergens ‘daarbuiten’, maar ieder idee daaromtrent was even waardevol. (Matt Hodges, geloofsovertuiging.nl)

Als we de waarheid niet meer kunnen onderscheiden in de vloed van nepnieuws, gaan we ook als christenen een uitdaging aan. Hoe kunnen we het Evangelie verspreiden wanneer de waarheid onkenbaar en dus een persoonlijke overtuiging is geworden? Hoe kunnen we een kerk bouwen wanneer geloofswaarheden alleen persoonlijk gekend worden?

Misschien gaat de hype rondom ChatGPT en anderen voorbij omdat we de waarde van menselijke waarheden hoger schatten. Dat een tekst die door een mens is geschreven waardevoller wordt gezien als een machine-gebaseerde tekst. Maar we kunnen binnenkort het verschil tussen beide niet meer onderkennen. Kwaadwillende mensen kunnen hun computerteksten altijd als menselijk laten doorgaan. We zullen sceptischer gaan staan op informatie we krijgen. Met het risico dat we ware teksten als onwaar gaan zien.

De vraag is hier niet of christendom de geopenbaarde waarheid is. De vraag is, is of dit feit door anderen als waarheid wordt gezien. In een wereld waar onwaarheden alom zijn en we twijfelen aan alles wat ons wordt verteld. Alleen ware oprechtheid van de verteller kan deze twijfel doorbreken. ‘Geloof’, aldus de Amerikaanse theoloog Stanley Hauerwas, ‘is niet bepaalde stellingen voor waar houden, hoewel het ook plaats heeft voor de houding en de passie van het vertrouwen. Geloof is niet een combinatie van die beide, maar eenvoudig loyaal zijn aan Jezus, als de stichter van Gods koninkrijk van vrede.

Reinoud Kaasschieter is expert op het gebied van kunstmatige intelligentie en ethiek bij Capgemini. Reinoud begeleidt ook de Alpha in zijn parochie. Hij schreef bovenstaande tekst op persoonlijke titel. Dit verhaal verscheen eerder op de website van Stichting Techthics en is met toestemming overgenomen door Cvandaag.

Praatmee